Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | |||||

| 3 | 4 | 5 | 6 | 7 | 8 | 9 |

| 10 | 11 | 12 | 13 | 14 | 15 | 16 |

| 17 | 18 | 19 | 20 | 21 | 22 | 23 |

| 24 | 25 | 26 | 27 | 28 | 29 | 30 |

Tags

- SQL

- 딥러닝

- 자바 실습

- 자바

- 컴퓨터비전

- numpy/pandas

- 데이터분석

- 중학1-1

- 정보처리기사필기

- 연습문제

- 데이터입출력구현

- 정보처리기사실기

- html/css

- 정수와유리수

- pandas

- 혼공머신

- 파이썬

- 중학수학

- C++

- 영어공부

- 텍스트마이닝

- 운영체제

- CSS

- 파이썬라이브러리

- 컴퓨터구조

- 머신러닝

- 코딩테스트

- JSP/Servlet

- CNN

- 데이터베이스

Archives

- Today

- Total

클라이언트/ 서버/ 엔지니어 "게임 개발자"를 향한 매일의 공부일지

다양한 분류 알고리즘 4 - 확률적 경사 하강법 2 : 스스로 실습하고 문제 풀어보는 시간 본문

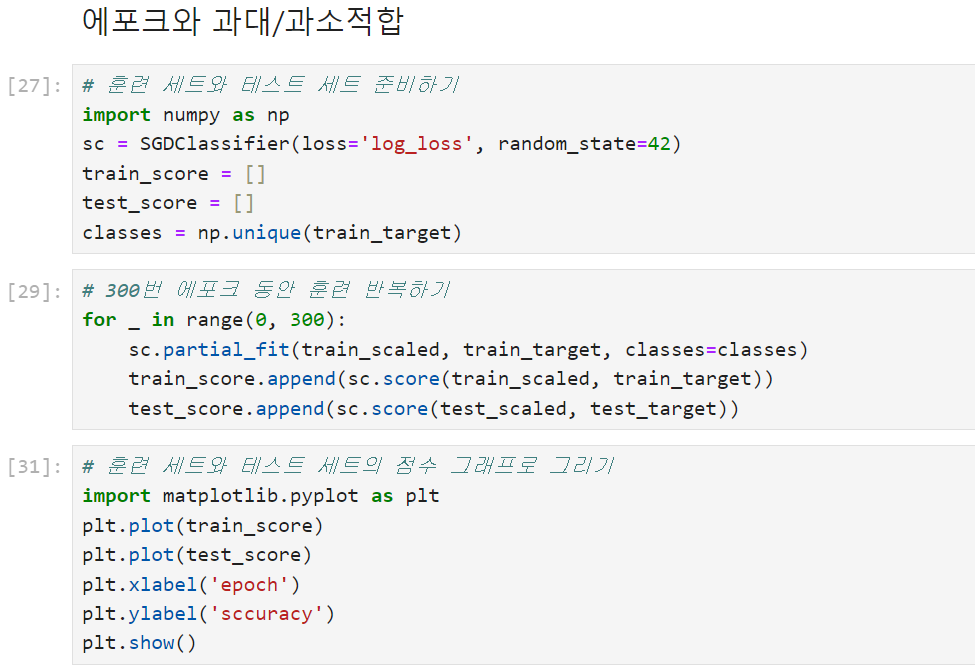

이제 확률적 경사 하강법을 실습해보려고 한다.

확률적 경사 하강법 실습해보기

백 번째 에포크 이후에는 훈련 세트와 테스트 세트의 점수가 조금씩 벌어지고 있다. 이 모델의 반복 횟수를 100에 맞추고 다시 훈련해보겠다.

단원 마무리하기

LinearRegression 클래스는 해석적인 방법으로 선형 방정식의 해를 구하는 구하기 때문에 특성의 스케일에 영향을 받지 않는다. KNeighborsClassifier는 최근접 이웃을 찾기 위해 샘플 간의 거리를 계산한다. 따라서 특성 스케일이 다르면 잘못된 이웃을 선택할 수 있다.

Ridge는 가중치를 규제하여 모델의 과대적합을 막는다. 특성의 스케일이 달라지면 이와 곱해지는 가중치의 스케일도 달라진다. 이렇게 되면 큰 가중치에만 관심을 두게 되어 가중치를 공정하게 규제하지 못한다.

SGDClassifier는 손실 함수를 최소화하기 위해 가장 가파른 경로를 찾는다. 특성의 스케일 때문에 가중치의 스케일에 차이가 크면 손실 함수를 최소화하는 경로를 올바르게 판단하지 못한다.

그러니까 답은 2번이다.

학습을 마치고

이렇게 4장의 모든 공부를 마쳤다. 언제나 내가 목표한 것보다 훨씬 느리게 학습이 진행된다. 그래도 조금씩 천천히 하는 게 오래동안 지치지 않고 가는 좋은 방법인 것 같다. 조금 쉬었다가 저녁에 다시 공부를 시작해보려고 한다.

'인공지능 > 머신러닝' 카테고리의 다른 글

| 트리 알고리즘 2 - 결정 트리 2 : 스스로 실습하고 문제 풀어보는 시간 (0) | 2024.09.29 |

|---|---|

| 트리 알고리즘 1 - 결정 트리 1 : 결정 트리 알고리즘으로 레드 와인과 화이트 와인 분류하기 (0) | 2024.09.29 |

| 다양한 분류 알고리즘 3 - 확률적 경사 하강법 1 : 확률적 경사 하강법과 손실 함수에 대하여 (0) | 2024.09.29 |

| 다양한 분류 알고리즘 2 - 로지스틱 회귀 2 : 스스로 실습하고 문제 풀어보는 시간 (0) | 2024.09.29 |

| 다양한 분류 알고리즘 1 - 로지스틱 회귀 1 : 로지스틱 회귀 알고리즘으로 클래스 확률 예측하기 (0) | 2024.09.29 |