| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | |||

| 5 | 6 | 7 | 8 | 9 | 10 | 11 |

| 12 | 13 | 14 | 15 | 16 | 17 | 18 |

| 19 | 20 | 21 | 22 | 23 | 24 | 25 |

| 26 | 27 | 28 | 29 | 30 | 31 |

- html/css

- 스프링프레임워크

- 스프링

- 디버깅

- ChatGPT

- 상속

- JDBC

- 중학수학

- 자바

- 데이터베이스

- rnn

- 쇼핑몰홈페이지제작

- 파이썬

- 개발일기

- 자바스크립트

- 연습문제

- 데이터분석

- 자바스크립트심화

- 정보처리기사필기

- 혼공머신

- 자바 실습

- 중학1-1

- 컴퓨터비전

- 머신러닝

- 딥러닝

- 정보처리기사실기

- JSP

- 타입스크립트심화

- SQL

- JSP/Servlet

- Today

- Total

"게임 개발자"를 향한 매일의 공부일지 1기 : 2024년 5 ~ 12월

[Spring반] 기말시험 3 - 딥러닝 시험 및 문제 풀이 본문

딥러닝 문제도 풀어보겠다.

딥러닝 문제

문제 11번

모든 과목의 첫 문제는 선생님이 거저먹기로 쉬운 문제를 내신 것 같다. 인공신경망(Artificial Neural Network, ANN)은 인간의 뇌 신경망을 모방하여 만들어진 컴퓨터 알고리즘으로, 여러 계층의 노드(뉴런)들이 연결되어 데이터를 처리하고 학습한다. 주로 패턴 인식, 예측, 분류 등 복잡한 문제를 해결하기 위해 사용된다.

문제 12번

이 문제도 무척 쉬웠다. 딥러닝에서 활성화 함수는 신경망에 비선형성을 부여하여 복잡한 패턴을 학습할 수 있도록 한다. 그러나 Linear(선형) 함수는 비선형성이 없기 때문에 활성화 함수로 사용될 때는 비선형 특성을 제공하지 않는다.

- Sigmoid: 출력값을 0과 1 사이로 제한하는 비선형 함수

- ReLU (Rectified Linear Unit): 0보다 작으면 0, 크면 그대로 출력하는 비선형 함수

- Softmax: 클래스 확률을 출력하기 위해 사용되는 비선형 함수로, 여러 출력값을 0과 1 사이의 확률로 변환

문제 13번

이 문제도 며칠 전에 모두 공부했던 내용이다. 드롭아웃으로 과대적합을 해소하는 실습을 진행했었다. 과대적합(Overfitting)은 딥러닝 모델이 학습 데이터에 너무 맞춰져, 새로운 데이터에 일반화되지 못하는 현상이다. 이를 방지하기 위한 방법 중 Dropout은 신경망의 일부 뉴런을 무작위로 비활성화하여 특정 뉴런에 의존하는 것을 줄임으로써 과대적합을 방지하는 효과적인 방법이다.

그 외에 다른 선택지를 살펴보자.

- 더 깊은 네트워크 사용: 모델이 더 복잡해져 과대적합이 오히려 더 심해질 수 있다.

- 학습 데이터양 줄이기: 데이터양을 줄이면 일반화 능력이 떨어져 과대적합을 오히려 악화시킬 수 있다.

- 학습률(Learning Rate) 감소: 학습률 조정은 과대적합보다는 학습의 안정성을 위해 사용되며, 과대적합 해결에는 큰 도움이 되지 않는다.

문제 14번

이 문제는 조금 헷갈리는 문제였다. 손실 함수는 딥러닝 모델이 예측한 값과 실제 값 사이의 차이를 측정하여, 모델의 학습을 평가하고 최적화하는 데 사용된다.

- PCA (Principal Component Analysis): 차원 축소 기법으로, 데이터의 분산을 최대화하는 축을 찾아 데이터를 낮은 차원으로 변환하는 데 사용된다. 손실 함수로 사용되지 않는다.

그 외에 답지를 살펴보자.

- MSE (Mean Squared Error): 회귀 문제에서 자주 사용되는 손실 함수로, 예측 값과 실제 값의 차이를 제곱하여 평균을 구한다.

- Cross-Entropy: 분류 문제에서 자주 사용되는 손실 함수로, 모델의 예측 확률과 실제 라벨 간의 차이를 측정한다.

- RMSE (Root Mean Squared Error): MSE의 제곱근으로, 예측 값과 실제 값의 차이를 측정하는 손실 함수이다.

따라서 답은 PCA이다.

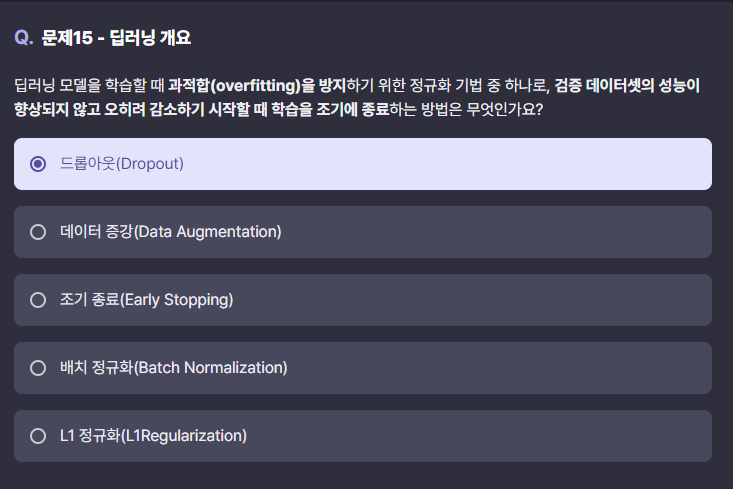

문제 15번

이 문제도 너무 쉬워서 문제를 캡처하기 전에 먼저 표시를 했다가 그냥 정답이 아닌 것에 표시했다.

답은 조기 종료이다. 조기 종료(Early Stopping)는 과적합을 방지하기 위한 정규화 기법 중 하나로, 모델이 학습 중 검증 데이터의 성능이 더 이상 향상되지 않고 오히려 감소할 때 학습을 중단하는 방법이다. 이는 모델이 과적합되지 않도록 학습을 조기에 멈춰서 일반화 성능을 향상하는 데 도움이 된다.

다른 선택지를 살펴보면 다음과 같다.

- 드롭아웃 (Dropout): 학습 시 일부 뉴런을 무작위로 비활성화하여 과적합을 방지하는 기법이다.

- 데이터 증강 (Data Augmentation): 이미지 회전, 확대 등 데이터 변형을 통해 학습 데이터의 다양성을 높이는 방법이다.

- 배치 정규화 (Batch Normalization): 각 미니배치마다 데이터의 분포를 정규화하여 학습을 안정화하고 성능을 향상시키는 기법이다.

- L1 정규화 (L1 Regularization): 모델의 복잡도를 줄이기 위해 가중치에 L1 패널티를 적용하여 특정 가중치를 0으로 만들어 가중치 값을 줄이는 방법이다.

시험을 마치고

딥러닝 문제는 어렵지 않게 풀었다. 공부를 안했다면 이 문제를 하나도 몰랐을 것이다. 하지만 요즘 딥러닝 공부를 열심히 해서 그런지 난이도가 쉽게 느껴질 정도였다.

남은 시각지능과 언어지능 문제도 풀어볼 것이다. 30분 정도 남았는데 그 안에 충분히 풀 수 있을 것이다.

'개발 포트폴리오 > 수료증 및 시험' 카테고리의 다른 글

| [Spring반] 기말시험 5 - 언어지능 시험 및 문제 풀이 (0) | 2024.10.31 |

|---|---|

| [Spring반] 기말시험 4 - 시각지능 시험 및 문제 풀이 (0) | 2024.10.31 |

| [Spiring반] 기말시험 2 - 컴퓨터 비전 시험 및 문제 풀이 (0) | 2024.10.31 |

| [Spiring반] 기말시험 1 - 머신러닝 시험 및 문제 풀이 (0) | 2024.10.31 |

| SQL로 데이터 다루기 기초 이수증 (0) | 2024.10.19 |