| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 | 31 |

- 자바스크립트

- 컴퓨터비전

- 쇼핑몰홈페이지제작

- 중학수학

- html/css

- 디버깅

- 중학1-1

- 데이터분석

- JDBC

- 정보처리기사필기

- 개발일기

- 순환신경망

- 파이썬

- 데이터베이스

- 혼공머신

- 자바 실습

- ChatGPT

- 타입스크립트심화

- rnn

- 연습문제

- 자바스크립트심화

- JSP/Servlet

- 머신러닝

- JSP

- 정보처리기사실기

- 스프링프레임워크

- SQL

- 자바

- 상속

- 딥러닝

- Today

- Total

클라이언트/ 서버/ 엔지니어 "게임 개발자"를 향한 매일의 공부일지

ChatGPT 이해 2 - ChatGPT 이론 본문

이번 시간에도 ChatGPT에 대한 학습이 이어진다. 앞 시간은 개관을 살펴보았다면 여기서는 좀 더 자세히 알아보는 시간이 될 것 같다.

이론 2 - ChatGPT 이론

Seq2Seq는 단어를 벡터인 숫자로 만든 다음 다시 단어로 뽑아내는 작업을 말한다.

king에서 woman을 더하고 man을 빼니 queen이 된다. 그 외에도 이런 신기한 결과가 나온다. 이것은 사람들이 많이 사용하는 단어를 집어넣어 숫자화한 것이다.

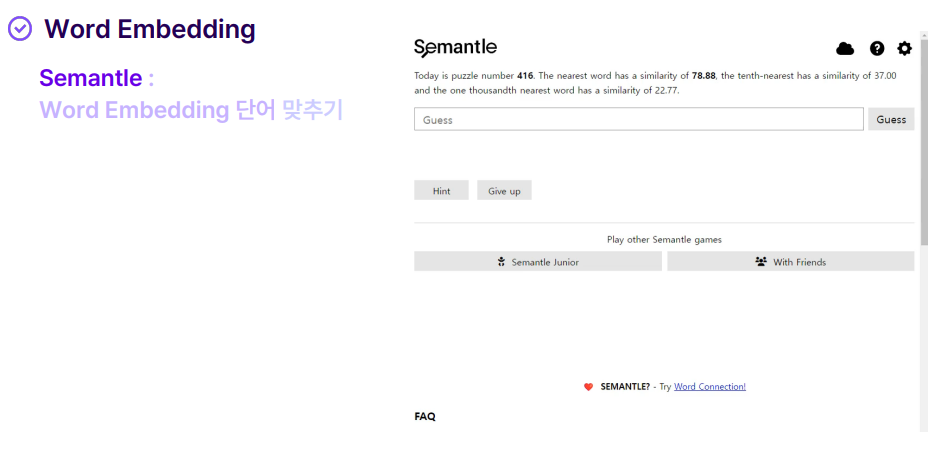

자신이 생각하는 단어를 넣으면 유사도가 얼마나 높은지 알려준다. 숫자가 낮을수록 유사하지 않고, 원래 생각했던 단어와 비슷해질수록 숫자가 높아진다.

이런 식으로 어떤 단어가 더 유사한 단어인지 보여준다.

단어가 하나씩 들어가서 나오는 상황이다.

원래 3개씩 들어가는데 만약 글자가 길 경우 나머지는 잘리고 세 글자만 디코딩된다. 긴 글자를 처리할 수 있는 대안이 필요해 attention이 등장한다.

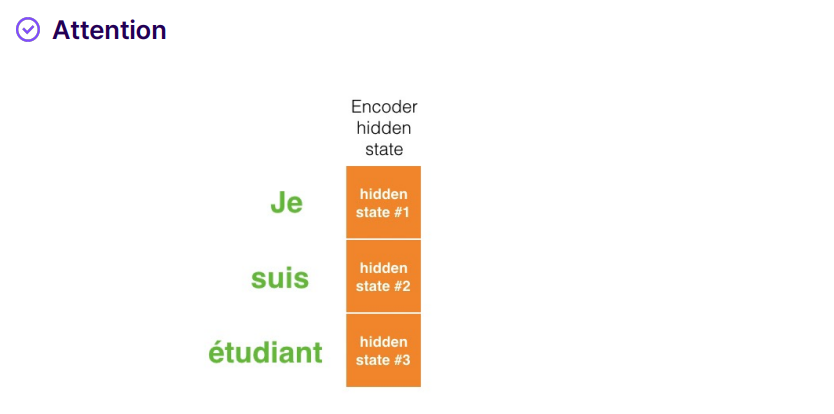

이렇게 긴 단어가 들어왔을 때를 생각해보자.

I라는 단어가 나오기 위해 어떻게 영향을 미쳤는지 관계를 기억하고 있는 것이다. 그렇기에 좀 더 멀리 있는 단어라도 관계를 예측할 수 있다.

이러한 단어가 있다고 생각해 보자.

I는 Je와 am은 suis와 가깝다고 예측하고 있다. 단어 간의 연결관계를 attention을 통해 파악할 수 있다.

인코더 디코더는 입출력 관계이다.

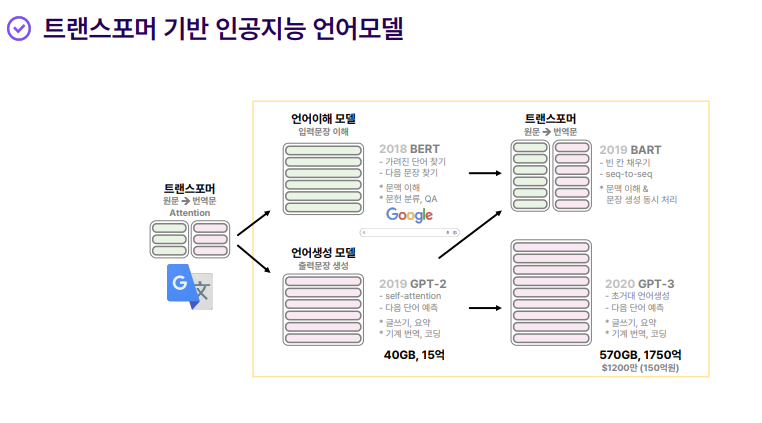

트랜스포머를 통해 단어들 간의 관계를 유추할 수 있다.

학습 데이터 문장이 있다고 할 때 이 문장의 일부를 가린다. 그리고 그 단어 다음에 A, Robot, Must가 나오도록 지시한다. 이렇게 하는 것이 자기지도학습이다.

이것이 ChatGPT의 원리이다.

학습하지 않아도 파라미터가 커질수록 새로운 능력이 생긴다는 것은 이런 의미이다. 공부를 계속하다 보면 어느 순간 학습이 잘 되어 어떤 학문이 이해되는 순간이 온다. 초거대 AI를 하려는 이유가 바로 이것이다.

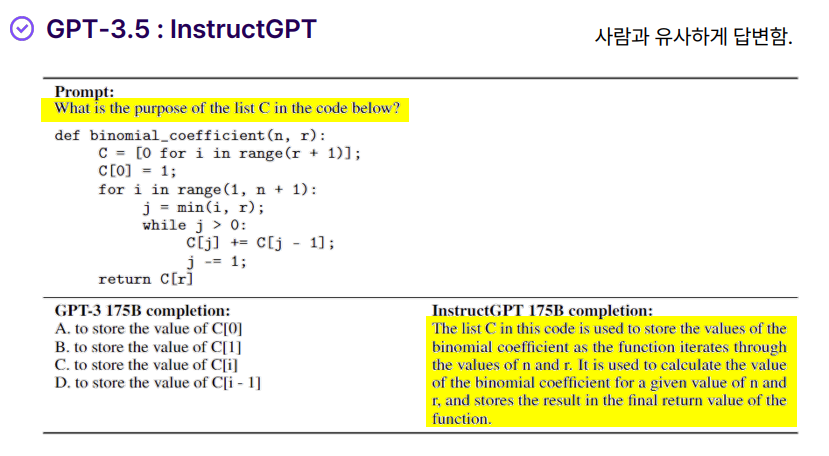

GPT 3.5에서는 사람과 유사하게 자연어로 대답하게 되었다.

이전 모델에서는 이상한 점을 찾지 못했지만 GPT 4에서는 차 뒤에서 다림질을 하는 것이 이상하다고 말하고 있다.

퀴즈 2 - ChatGPT의 원리

학습을 마치고

이번 단원도 무척 배울 게 많고 긴 수업이었다. 지금은 자세한 내용을 다 알 수는 없지만 이런 게 있구나 하고 넘어가려고 한다. 더 깊은 내용은 나중에 생성 AI를 공부하면서 알아볼 것이다. 그 책에 오늘 배운 것들이 나와있는 것 같았다.

그래도 나름 재미있는 수업이었다.

'인공지능 > 프롬프트 엔지니어링 & 생성형 AI' 카테고리의 다른 글

| ChatGPT 이해 4 - 정보 보호 (0) | 2024.12.21 |

|---|---|

| ChatGPT 이해 3 - 할루시네이션 (0) | 2024.12.21 |

| ChatGPT 이해 1 - ChatGPT 개요 (0) | 2024.12.21 |

| 거대 언어 모델(LLM)이란? 4 - few tunnig Vs Prompt Engineerning과 LLM의 주요 활용 분야 (0) | 2024.12.21 |

| 거대 언어 모델(LLM)이란? 3 - GPT를 통해 알아보는 LLM의 등장 2 : 퀴즈 문제 풀기 (0) | 2024.12.21 |