| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 | 31 |

- JSP

- 자바스크립트심화

- html/css

- 쇼핑몰홈페이지제작

- ChatGPT

- 중학1-1

- SQL

- 연습문제

- 자바

- 디버깅

- 딥러닝

- 혼공머신

- JDBC

- 머신러닝

- 데이터베이스

- 중학수학

- 데이터분석

- JSP/Servlet

- 개발일기

- 정보처리기사필기

- 정보처리기사실기

- 순환신경망

- 파이썬

- 자바스크립트

- 컴퓨터비전

- 자바 실습

- 상속

- rnn

- 스프링프레임워크

- 타입스크립트심화

- Today

- Total

클라이언트/ 서버/ 엔지니어 "게임 개발자"를 향한 매일의 공부일지

거대 언어 모델(LLM)이란? 2 - GPT를 통해 알아보는 LLM의 등장 1 : 이론 학습 본문

거대 언어 모델(LLM)이란? 2 - GPT를 통해 알아보는 LLM의 등장 1 : 이론 학습

huenuri 2024. 12. 21. 06:13이어서 거대 언어 모델에 대해서 공부해 보겠다. LLM이라는 용어는 가끔씩 들어보았는데 이게 무엇인지는 잘 몰랐었다. 이 단원에서는 ChatGPT에 대해 좀 더 구체적으로 학습하게 될 것 같다.

이론 2 - GPT를 통해 알아보는 LLM의 등장

이러한 개념으로 GPT-1이 등장했다.

이미 정답이 없는 데이터로 사전 학습을 했기 때문에 적은량의 정답이 있는 데이터로 학습해도 좋은 성능을 보이게 된다.

대부분의 사람들은 물음표에 답을 채우는데 별 어려움이 없지만 GPT-1에서는 많은 데이터와 미세 조정이 필요했다.

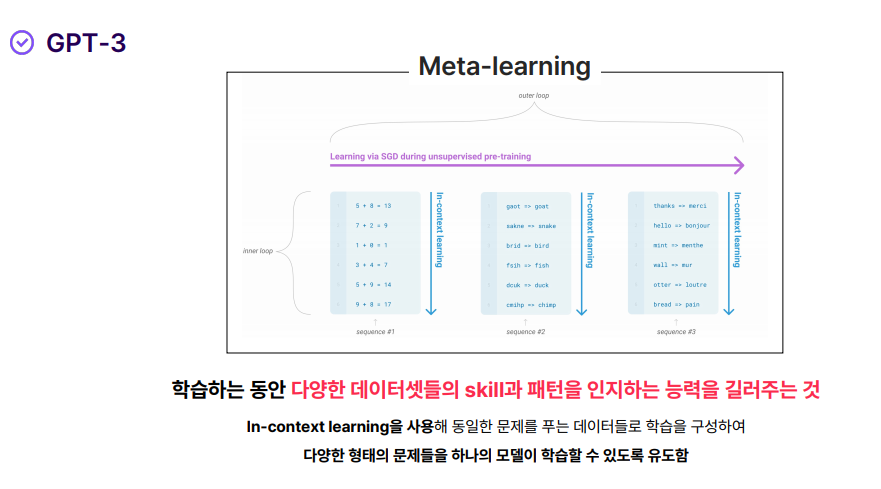

In-context learning은 과제에 대한 설명과 예시와 프롬프트 내용만으로 태스크를 수행하는 과정을 말한다.

하나의 시퀀스에 동일한 문제를 풀 수 있도록 데이터를 구성하고, 매 시퀀스마다 다양한 형태의 문제들로 구성하는 것이다.

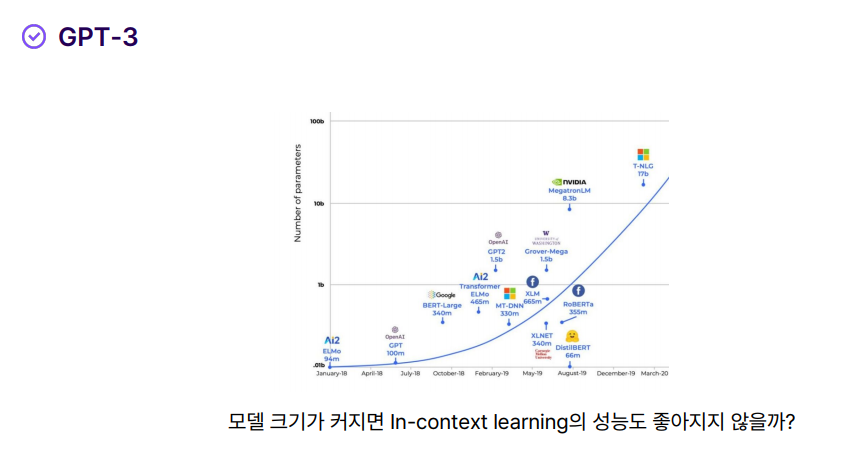

파라미터의 수가 이처럼 기하급수적으로 커졌다.

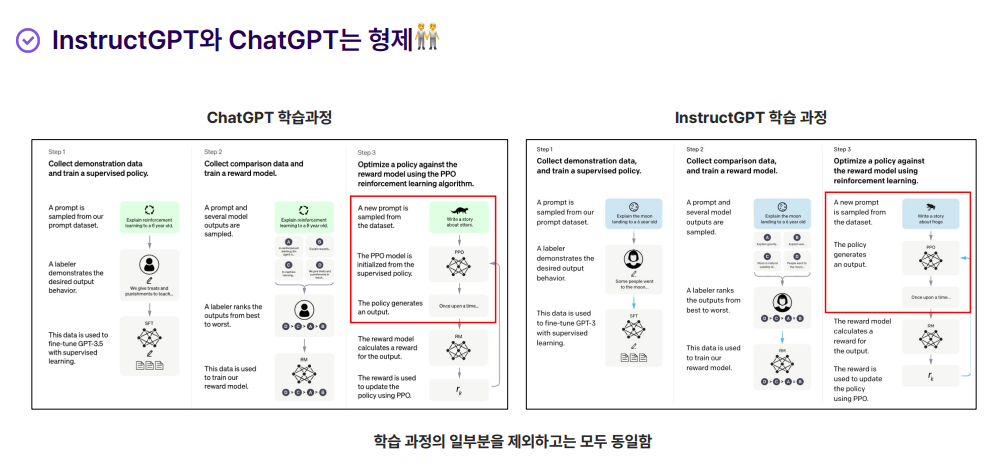

강화 학습은 보상을 최대화하는 방향으로 학습이 진행된다. 이렇게 생성된 모델을 바탕으로 보상 모델이 사용된다. 그러면 GPT는 이 보상이 최대화되도록 학습한다.

ChatGPT는 존을 왕따시키지 않는 방법을 알려주지만, IntructGPT는 존을 왕따 시키는 방법에 대해서 알려주고 있다.

이 이미지에 대해 웃긴 점을 말해달라고 했을 때 이미지를 읽어나가고 답변을 하는 것을 볼 수 있다.

학습을 마치고

이번 단원에서는 학습 분량이 무척 많아서 퀴즈는 다음 포스트에서 학습하기로 하겠다. GPT의 발전 역사에 대해서 상세하게 들을 수 있어서 매우 유익한 수업이었다. 이 과목을 선택하길 정말 잘했다는 생각이 든다.

보통 강의를 들을 때 난 1.5배속으로 듣는데 이 선생님은 말 속도가 빨라서 1.25로 들으면 더 이해가 되기도 했지만 강의 속도가 더 빠를 때 집중이 훨씬 잘 되는 편이다. 그냥 빠르지만 놓치면 다시 듣더라도 1.5배속으로 들었다.

그래도 언어 모델 관련 수업들을 다른 수업과 달리 1년 전에 만들어진 수업이라서 나름 괜찮은 것 같다. 다른 수업들은 3년 이상 된 수업들이 대부분이었다.

'인공지능 > 프롬프트 엔지니어링 & 생성형 AI' 카테고리의 다른 글

| 거대 언어 모델(LLM)이란? 4 - few tunnig Vs Prompt Engineerning과 LLM의 주요 활용 분야 (0) | 2024.12.21 |

|---|---|

| 거대 언어 모델(LLM)이란? 3 - GPT를 통해 알아보는 LLM의 등장 2 : 퀴즈 문제 풀기 (0) | 2024.12.21 |

| 거대 언어 모델(LLM)이란? 1 - 거대 언어 모델이란 (0) | 2024.12.21 |

| 프롬프트 비식별화 3 - 프롬프트 비식별화 실습 (0) | 2024.12.20 |

| 프롬프트 비식별화 2 - 식별자 마스킹과 가짜 식별자 생성 (0) | 2024.12.20 |